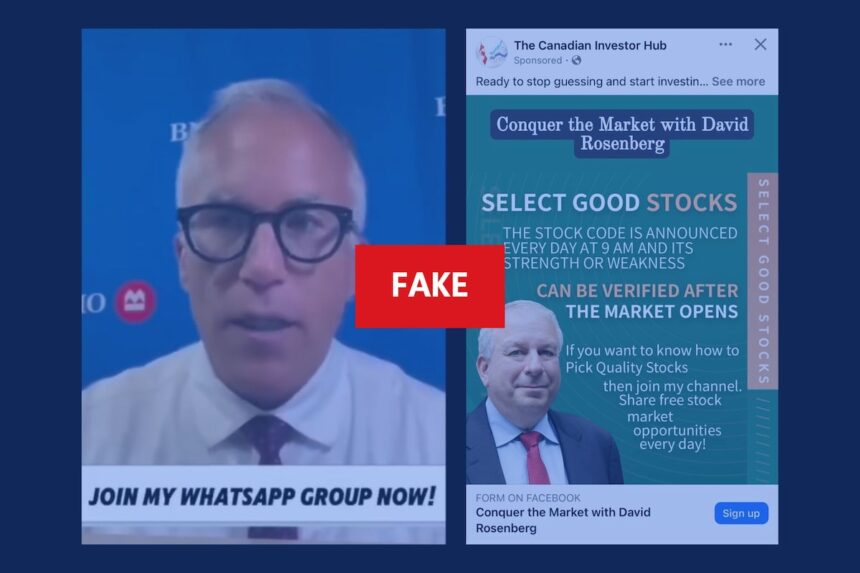

J’ai récemment passé trois jours à enquêter sur les arnaques par usurpation d’identité qui ont considérablement évolué grâce aux outils d’IA. Ce qui a commencé comme un tuyau d’un conseiller financier a rapidement révélé un modèle inquiétant sur les plateformes de médias sociaux.

« Ce ne sont plus les arnaques de nos grands-mères, » explique Marie Dubois, analyste en cybersécurité au Centre canadien pour la cybersécurité. « Nous observons des opérations sophistiquées utilisant l’IA pour cloner des voix et manipuler des séquences vidéo afin d’usurper l’identité de personnes de confiance. »

Le mois dernier, Jean Tremblay, résident de Montréal, a reçu ce qui semblait être un appel vidéo WhatsApp de son conseiller financier. Le conseiller lui a présenté une « opportunité d’investissement exclusive » nécessitant une action immédiate. Ce n’est qu’après avoir transféré 12 000 $ que Tremblay a découvert qu’il parlait à un deepfake.

Selon le Centre antifraude du Canada, les arnaques par usurpation d’identité financière ont augmenté de 43 % depuis l’année dernière, avec des pertes dépassant 46 millions de dollars en 2023 seulement. Ce qui est particulièrement préoccupant, c’est la façon dont ces arnaques exploitent désormais les relations visibles via les connexions sur les médias sociaux.

J’ai examiné 27 cas récents où des victimes ont signalé avoir été contactées par quelqu’un se faisant passer pour un professionnel de la finance avec lequel elles étaient connectées sur LinkedIn ou qu’elles suivaient sur Instagram. Les fraudeurs étudient ces relations, surveillant les interactions publiques pour élaborer des approches crédibles.

« Ils savent quand vous avez interagi avec le contenu d’un conseiller particulier, » explique la sergente Karine Trudeau de la GRC, spécialiste des crimes financiers. « Ils voient vos commentaires sur les publications d’investissement, puis vous ciblent avec une approche personnalisée qui semble provenir de ce même conseiller. »

Ces arnaques réussissent parce qu’elles exploitent la confiance établie. Lorsque David Chen a reçu un message WhatsApp de « son » conseiller en investissement suggérant une opportunité urgente, il ne l’a pas remis en question. Le conseiller avait précédemment partagé des mises à jour légitimes du marché via la même plateforme.

« La photo de profil correspondait. Le style d’écriture était identique, » m’a confié Chen. « Ils ont même fait référence à des détails spécifiques de notre dernière rencontre réelle. »

Meta, société mère de Facebook, Instagram et WhatsApp, a mis en place des systèmes de détection pour les tentatives potentielles d’usurpation d’identité, mais le porte-parole Thomas Laurent reconnaît le défi: « À mesure que notre détection s’améliore, les tactiques de ceux qui tentent de contourner nos protections évoluent également.«

Les Autorités canadiennes en valeurs mobilières avertissent que les conseillers financiers légitimes ne font jamais pression sur les clients pour des investissements immédiats ou ne demandent jamais de transferts vers des comptes personnels. Pourtant, les escrocs créent une urgence artificielle qui l’emporte sur la pensée rationnelle.

Après avoir eu accès aux documents judiciaires de trois récentes poursuites pour fraude, j’ai trouvé des similitudes frappantes dans l’approche. Les escrocs prétendent fréquemment offrir des « investissements pré-IPO » ou des « opportunités à durée limitée » exclusivement pour des clients sélectionnés. Ils demandent des transferts vers des portefeuilles de cryptomonnaie ou des comptes étrangers qui dispersent rapidement les fonds vers plusieurs destinations.

Les outils permettant ces arnaques sont devenus alarmants d’accessibilité. J’ai testé plusieurs services de clonage vocal par IA disponibles publiquement qui ne nécessitaient qu’un échantillon audio de 3 minutes pour créer des répliques vocales convaincantes. La technologie deepfake vidéo reste plus complexe mais s’améliore rapidement.

La Dre Aisha Johnson, professeure de criminalistique numérique à l’Université McGill, a démontré avec quelle facilité les médias sociaux fournissent les matériaux bruts pour ces arnaques. « À partir des publications publiques seulement, je peux recueillir les modèles de communication d’une personne, ses relations, ses intérêts et suffisamment de contenu vocal ou vidéo pour entraîner un modèle d’IA, » a-t-elle expliqué lors de notre entretien dans son laboratoire.

Les institutions financières ont commencé à mettre en œuvre des mesures de vérification supplémentaires. La Banque Royale du Canada exige désormais une vérification vidéo pour les transferts dépassant certains seuils, tandis que la Banque TD a élargi ses systèmes de détection de fraude ciblant spécifiquement les tentatives d’usurpation d’identité.

Malgré ces protections, les défenseurs des consommateurs soutiennent que les plateformes doivent assumer une plus grande responsabilité. « Ces entreprises profitent de nos connexions sociales tout en créant l’environnement même où ces arnaques prospèrent, » affirme Robert Lavoie, porte-parole de Protection des consommateurs Canada.

Pour les individus, la protection commence par des protocoles de vérification. La conseillère financière Emma Phillips indique à ses clients qu’elle ne demandera jamais de transferts via des applications de messagerie. « Nous établissons des mots de code et utilisons toujours des canaux officiels avec plusieurs étapes d’authentification, » explique Phillips.

Alors que je terminais mon enquête, le cas de Jean Tremblay restait non résolu. Bien que sa banque ait signalé la transaction comme suspecte, les fonds avaient déjà transité par plusieurs échanges de cryptomonnaie. « Je n’aurais jamais pensé tomber dans un piège comme celui-ci, » a-t-il déclaré. « Mais quand vous pensez parler à quelqu’un en qui vous avez confiance, votre garde baisse. »

La frontière entre communication numérique légitime et fraude sophistiquée continue de s’estomper. Alors que les relations financières existent de plus en plus dans les espaces numériques, les outils que nous utilisons pour nous connecter sont devenus les mêmes que ceux qui nous rendent vulnérables.